パターン認識・画像理解

歩き方の個性に基づく個人認証

| 特記事項:

歩容データベースOU-ISIR Gait Databaseを公開しています. |

| 歩容認証におけるセンサ最適配置 |

|

|

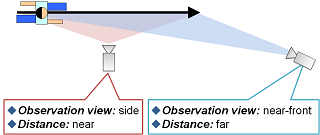

近年,歩き方の個性に基づく個人認証手法が数多く提案されているが,実用化に 当たっては認証性能を最大化するようなカメラの最適配置が必要となる.そこで 本論文では,様々な観測条件を包括的に考慮した認証性能モデルを構築すること で,最適なカメラ配置を解析する.まず,認証性能に影響を与える観測条 件として,歩行者の解像度・局所的及び大域的な観測角変化・観測方向に着目す る.次に,いくつかのカメラ配置に対して歩容認証実験を行い,観測条件と認証 性能からなる学習セットを生成する.そして,学習セットに対してガウス過程回 帰を適用することで,観測条件を入力として認証性能を出力とする認証性能モデ ルを構築する.最後に,認証性能モデルを用いて,カメラ配置から認証性能を推 定することで,最適なカメラ配置を求める.実験では,17人の被験者の直線歩行 シーケンスからなる学習セットを用いて認証性能モデルの構築し,カメラの最適 配置を求めることで提案手法の有効性を確認した. |

|

|

| 歩容における性別・年齢の分類と特徴解析 |

|

|

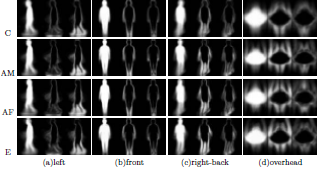

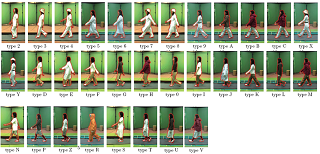

本論文では歩容における性別・年齢の分類を決定し,その分類にあらわれる歩容特徴の解析を行う.まず全25台のカメラからなる多視点同期歩容撮影システムを構築し,広い年齢層の被験者の歩容を撮影することで大規模歩容データベースを構築した.性別,年齢それぞれに関して識別実験を行い,その結果に基づき,性別・年齢識別に適した分類として,子供,成人男性,成人女性,高齢者という4つのクラスを求めた.それらのクラス,及び特定の2クラスに対して,観測方向による識別性能への影響を実験を通して確認した.また,各観測方向においてクラスに特有な特徴がどの部位に現れるかを解析した.結果として,コンピュータビジョンの観点から次のような知見が得られた.(1) クラスを象徴する歩容特徴はクラスによって異なり,またそれがよく観測できる方向も異なる.(2) そのため,識別するクラスによっては,真横といった典型的に用いられる観測方向より効果的な観測方向が存在する. |

|

|

| 大規模歩容データベースを用いた歩容認証手法の性能評価 |

|

|

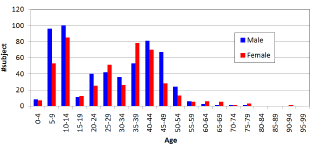

近年,歩き方の個性に基づく個人認証手法が提案されているが,その性能評価は高々100 人程度のデータベースに対してしか行われておらず,その統計的な信頼性は十分ではない.そこで本研究では,まず世界最大となる2 歳から94 歳までの幅広い年齢層の男女計1035 人からなる大規模歩容データベースを構築した.次に,代表的な既存歩容特徴である平均シルエット,周波数領域特徴,固有空間における軌跡特徴による認証実験を行った.認証性能はCMC 曲線及びROC 曲線により評価し,データベースから抽出した100 人と全体の1035 人に対する結果を比較することで,大規模データベースの必要性を示す. |

|

|

| クラスタペアに基づく判別分析 |

|

|

パターン認識において,状況変化に起因するクラス内変動がクラス間変動を上回り,認識率が低下することがある.本論文では,そのような状況変化のクラスタペアに着目した判別分析手法を提案する.学習段階においては,認証対象以外の学習用クラスについて様々な状況下での学習データを用意し,状況クラスタの判別空間と各状況クラスタペアに限定した場合のクラス判別空間を構築する.一方,テスト段階において認証対象のクラスについての照合データ対が与えられると,まずその状況クラスタペアを推定し,次いで対応する状況クラスタペアのクラス判別空間における距離を計算することで,クラス識別を行う.実験では,シミュレーションデータ及び服装変化を伴う歩容シーケンスの実データに対するクラス識別を行い,提案手法の有効性を確認した. |

| ROC曲線最適化のための適応的閾値制御 |

|

|

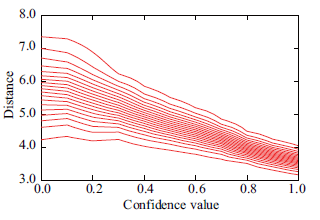

ROC 曲線は,1 対1 認証や特定物体検出等の2 クラス識別問題において,照合度に対する受け入れ閾値を変化させたときの偽陽性率と偽陰性率のトレードオフを示す曲線である.本論文では,状況変化の度合いに関連した信頼度付きの照合度に対して,受け入れ(検出) 閾値を信頼度に応じて適応的に制御する手法を提案する.ROC 曲線最適化の観点に基づくと,照合度と信頼度の2 次元空間における閾値曲線群が,全体の受け入れ率に対する偽陽性と偽陰性率の総誤り率の比として定義される誤り勾配の等値線と一致することを示す.シミュレーションデータ及び実データを用いた実験により,特に偽陽性率と偽陰性率のいずれか一方の許容誤り率が小さい条件において,提案手法が有効であることを確認した. |

|

|

| 低フレームレート映像のための歩容認証 |

|

|

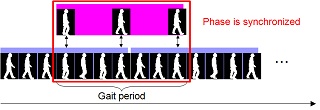

近年,広域監視や犯罪捜査等を目的として人の歩き方の個性に基づく個人認証である歩容認証が注目を集めている.一般的に,防犯カメラによる映像は通信帯域や記録装置の容量の制限から,低時空間解像度で撮影されていることが多く,標準的な時間解像度を想定した従来の歩容認証手法を適用することは困難である.本研究では,歩容を固有空間における軌跡として捉え,映像の時間解像度と歩行周期を考慮した時間伸縮と時間シフトによる歩容位相同期手法を提案する.また,シーケンス内の歩容の揺らぎを考慮して,歩行周期を単位とした照合結果を統計的に処理することで,頑健な照合を行う.実験では,時空間の両方の解像度に関する認証性能評価を行い,本手法の有効性を確認した. |

|

|

| ディジタルエンタテインメントのためのオンライン歩容個性計測 |

|

|

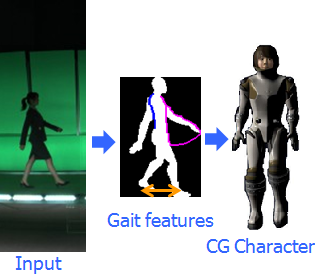

本論文では, 視聴者参加型デジタルエンタテインメントで用いるための歩容個性をオンライン計測し, 歩容個性をCG キャラクタへ反映する手法を提案する. まず歩容映像から容易に歩容シルエット画像列を抽出するため,クロマキー用背景及び照明を含む歩行路で構成されるオンライン歩容計測装置を設計する.次に, 得られたシルエット画像列から, 体型や身長のような歩容動作とは独立な静的特徴と, 歩幅や腕の振り幅のような歩容動作に関わる動的特徴を計測する. 一方,あらかじめ様々な歩容個性を持つCG キャラクタの体型と動作に関するパラメータをモーションキャプチャ等を用いて抽出し, そのパラメータによる合成シルエットを作成し,それらの対を標準モデルとして登録しておく.最後に,標準モデルをブレンドして視聴者の歩容個性を再現するために,標準モデルから抽出した歩容個性の重み付き線形和とオンライン計測した歩容個性の誤差を最小にするように重み(ブレンド率) を推定する.実験では大規模歩容データベース100 人に対する歩容個性解析を行い, CG キャラクタへ歩容個性が反映されることを確認した. |

|

|

| 服装変化に頑健な歩容認証 |

|

|

Variations in clothing alter an individual's appearance, making the problem of gait identification much more difficult. If the type of clothing differs in a gallery and a probe, certain parts of the silhouettes are likely to change and the ability to discriminate subjects decreases with respect to these parts. A part-based approach, therefore, has the potential for selecting the appropriate parts. This paper proposes a method for part-based gait identification in light of substantial clothing variations. We divide the human body into 8 sections, including 4 overlapping ones, since the larger parts have a higher discrimination capability while the smaller parts are more likely to be unaffected by clothing variations. Furthermore, as there are certain clothes that are common to different parts, we present a categorization for items of clothing to group similar clothes. Next, we exploit the discrimination capability as a matching weight for each part and control the weights adaptively based on a distribution of distances between the probe and all the galleries. The results of the experiments using our large-scale gait dataset with clothing variations show that the proposed method achieves far better performance than other approaches. |

|

|

| 速度変化に頑健な歩容認証 |

|

|

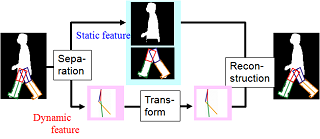

近年,遠方の人物が認証可能な歩容認証が注目されている.歩容認証には歩行速度の変化に応じた歩容特徴量の変化という問題点がある.そこで本研究では速度変化に応じて,ある速度の歩容シルエット列を異なる速度のシルエット列に変換する手法を提案する.本手法は,まず人物モデルを用いて歩容シルエット列から静的特徴量と動的特徴量を分離する.次に,あらかじめ複数被験者における複数速度の動的特徴量を学習して,速度変換モデルを生成し,参照速度から異なる速度の動的特徴量に変換する.最後に,分離した静的特徴量および変換した動的特徴量を用いてシルエット列を復元する.また周波数領域特徴による個人認証実験により本手法の有効性を確認した. |

|

|

| 全方位カメラを用いた多方向照合による歩容認証 |

|

|

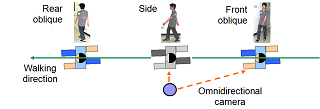

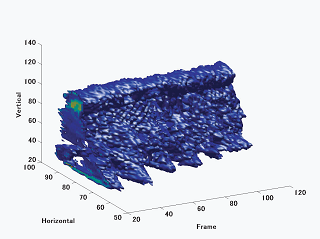

本研究では,全方位カメラから得られる複数方向の歩容画像を用いた個人認証手法を提案する. 最初に背景差分により全方位画像列からシルエットを抽出する. それをパノラマ展開し,時空間の歩容シルエットボリューム(GSV) を得る. 次にGSV から算出した歩行周期に基づいてフーリエ解析を行い,周波数領域特徴を抽出する. また全方位カメラを用いることによる観測方向の変化を利用して,複数の基準方向を設定し,各基準方向と歩行周期を基に複数方向の特徴を抽出する. 認証時には,入力と辞書シーケンスに対する同一方向同士の特徴間距離を算出し,それらを統合して照合を行う. 最後に21 人の被験者の5 方向を含むシーケンスに対して個人認証実験を行い,本手法の有効性を確認した. |

|

|

| 方向変化に伴う体の傾きを考慮した歩容認証 |

|

|

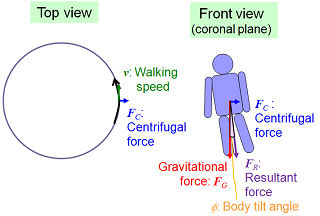

近年,カメラから離れた場所での個人認証手法として,歩容認証が注目を集めている.しかし,歩行者が曲がり道を歩く場合や,道から建物に入る場合には歩行方向が徐々に変化し,その際の遠心力の影響で体が傾くため,歩容認証が困難となる.そこで,本研究では最初に,歩容シルエットの時空間ボリュームから抽出される周波数領域特徴と方向変換モデルを用いた歩容認証手法を導入する.次に,人物追跡によって得られる歩行軌跡を基に遠心力及び体の傾き角度を推定することで,歩容シルエットを補正する.最後に,方向変化を伴う円軌跡の歩行に対する認証実験を行い,本手法の有効性を確認した. |

|

|

| 周波数領域における方向変換モデルを用いた歩容認証 |

|

|

近年,カメラから離れた場所での個人認証手法として,歩容解析が注目を集めている.歩容認証の問題点として,歩行方向やカメラの視線方向の変化に伴う見えの変化が挙げられる.本研究では,周波数領域特徴と方向変換モデルを用いた歩容認証手法を提案する.最初に時系列の歩容シルエットで構成される時空間ボリュームから,フーリエ解析によって周波数領域特徴を抽出する.次に,複数被験者の複数方向の特徴を用いて,方向変換モデルを学習する.認証時には,方向変換モデルによって,登録人物の特徴を入力特徴と同じ方向の特徴に変換して,照合を行う. |

|

|

| 歩容の時空間解析 |

|

|

This paper describes a new approach for identifying a person from a spatio-temporal volume that consists of sequential images of a person walking in an arbitrary direction. The proposed approach employs an omnidirectional image sensor and analyzes the three dimensional frequency properties of spatio-temporal volume, because the sensor can capture a long image sequence of a person's movements in all directions, and, as well, their walking patterns have some cycles. Spatio-temporal volume data, here called ``gait volume'', contain information not only of spatial individualities such as features of the torso and face, but also movements of their torso within a unique rhythm. Three dimensional fourier transform is applied to the gait volume to obtain a unique frequency for each person's walking pattern. This paper also evaluates the availability of three dimensional frequency analysis of the gait volume, how much is the difference in frequency patterns while walking. |

|

|